矩阵的奇异值分解

Besides having a rather simple geometric explanation, the singular value decomposition offers extremely effective techniques for putting linear algebraic ideas into practice.

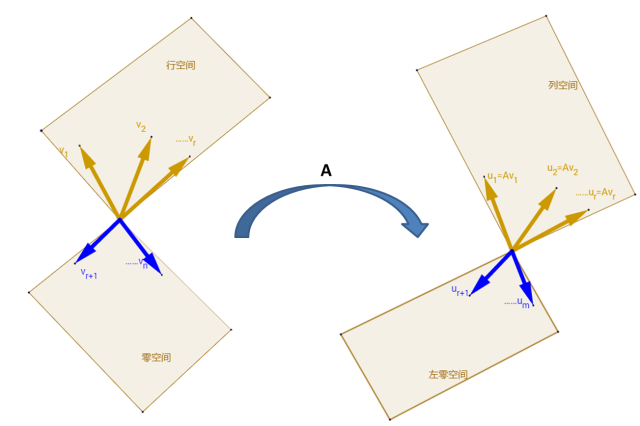

SVD分解与四个子空间

任意的线性变换都可以进行奇异值分解(SVD: Singular Value

Decomposition)。之前的一篇博客讲的特征值和特征向量都是针对方阵而言的.这里任意形状的矩阵都能够进行SVD变换。给定一个

(

写成更简单的形式是:

矩阵对行空间向量的变换 2025-06-13

费这么大的劲把矩阵的最本质的东西提取出来,一定是有目的的:

我们希望了解,任何一个矩阵,它在

我们希望给定任何一个向量:

因为

写成矩阵形式:

- 所以主要工作量主要是第一步,求投影的拉伸系数。

- 矩阵对输入向量的变化,在一些方向上变换较大,在另一些方向变换较小,实际生产生活中,只是去关注变换较大的方向,忽略变换较小的方向:挑选那些较大

奇异值分解的几何意义

接上面的矩阵定义

(

(

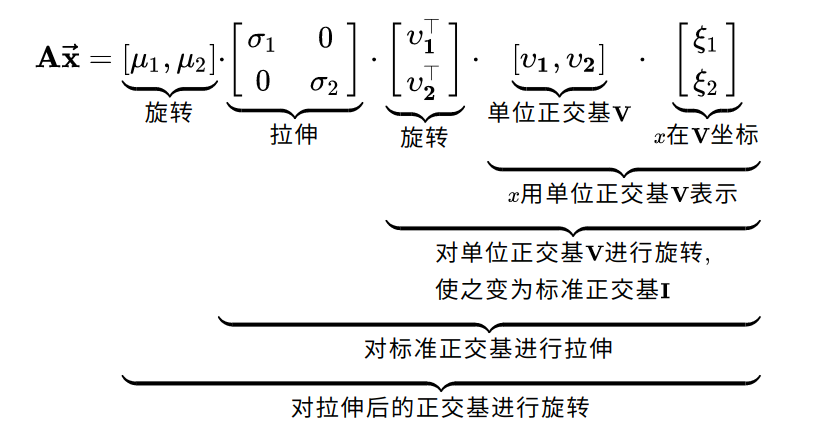

最近在知乎上又看到了硬核机器学习文章分享的回答,在他的回答中,两组正交基分别就是矩阵行空间、列空间的标准正交基。如果不好记忆的话,我们可以对比矩阵和向量的乘法,

总结一下

步骤如下:

给出任意向量

矩阵对该向量的变换分解为如下

投影

使用

使用奇异值拉伸

使用

和特征值分解的关系

刚才只讨论了矩阵行空间和列空间的向量,那么,剩下的零空间和左零空间的向量难道就放弃了么?并不是这样的,出于考虑问题的完备性,我们写出如下的表达式

SVD更广泛的意义是将

参考材料

We Recommend a Singular Value Decomposition "奇异值分解的直观理解"